Expectation Maximization EM 算法

EM 算法介绍

对于未观测的变量,隐变量 latent variable,无法直接求解极大似然估计,此时考虑边际似然。

令表示已观测变量集,表示隐变量集,表示模型参数。

欲对做极大似然估计,则应最大化对数似然

然而由于是隐变量,上式无法直接求解。此时我们可通过对计算期望,来最大化已观测数据的对数”边际似然” marginal likelihood

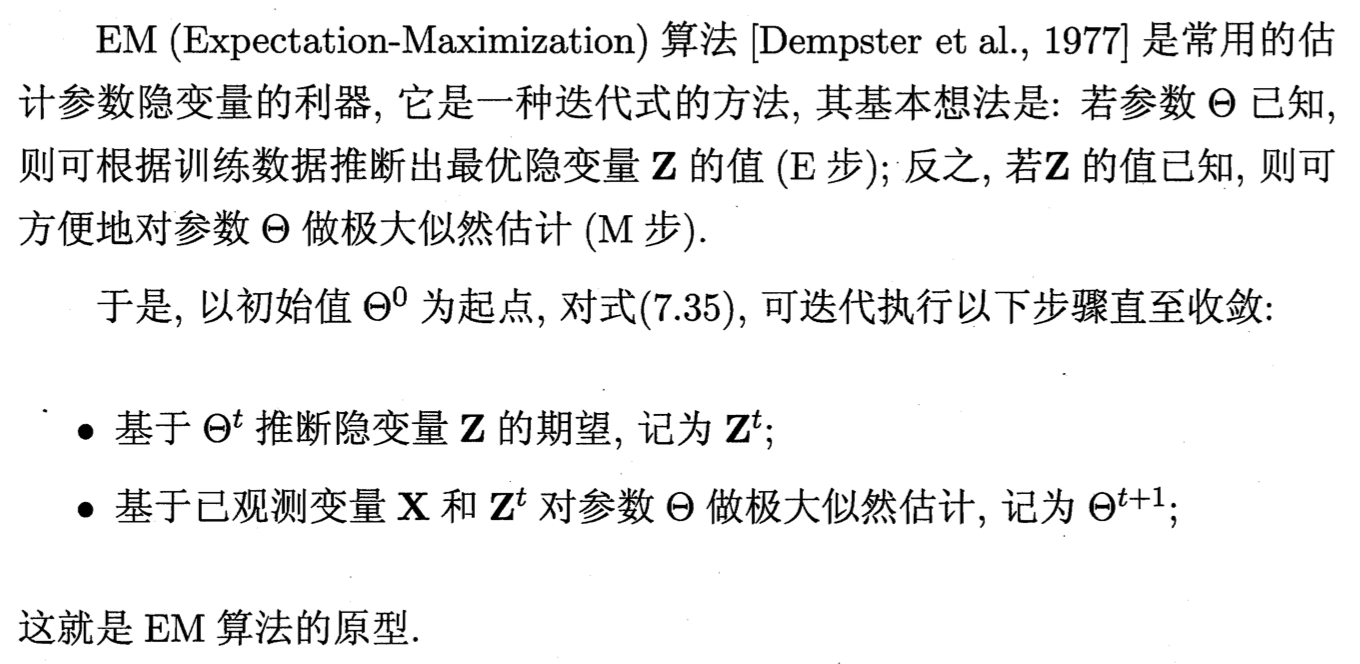

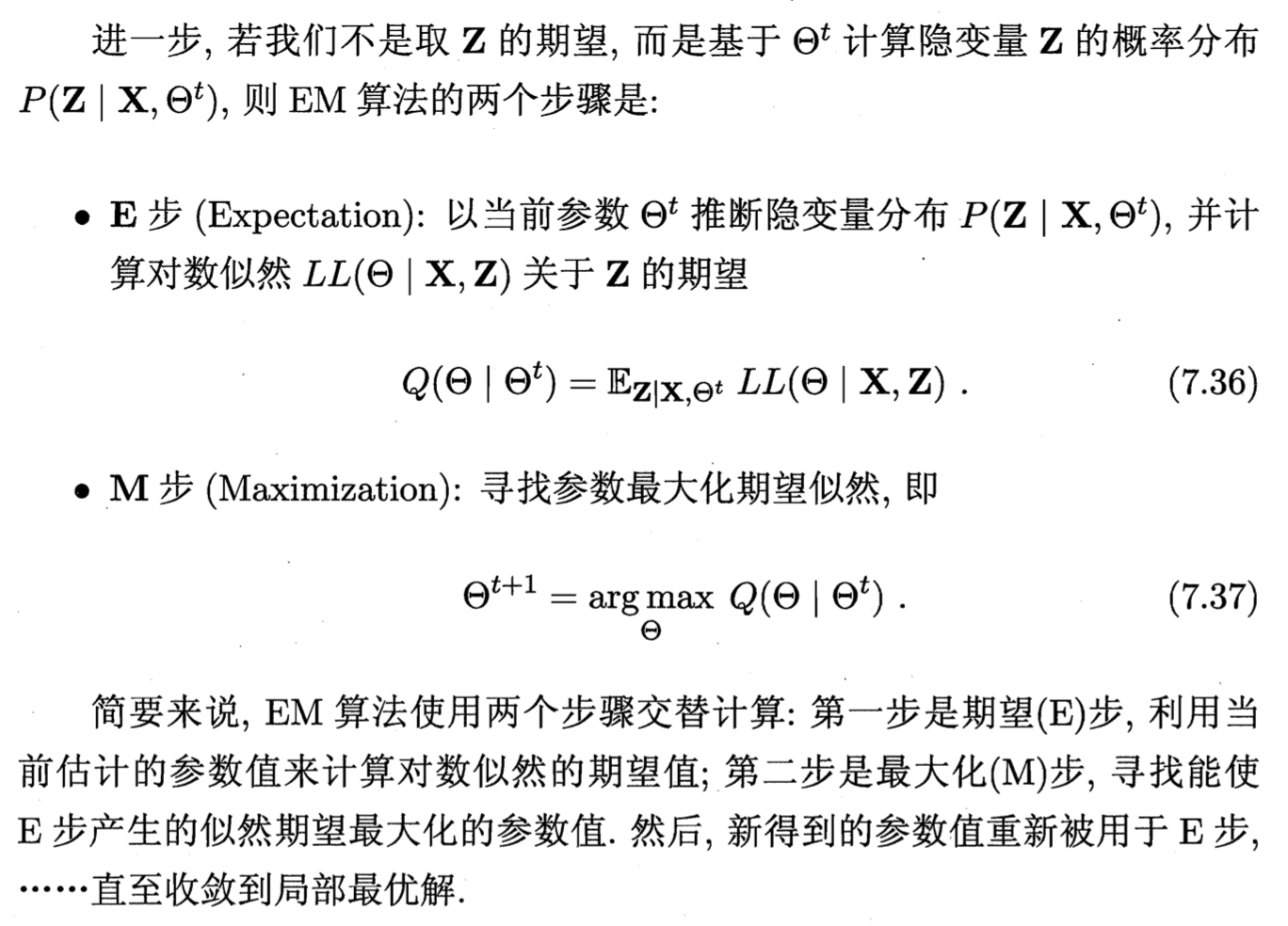

EM 算法是估计参数隐变量的利器,是一种迭代式的方法。简单地说,EM 就是先由目前的 distribution ,推测出 missing data 最适合的 distribution,再由已知的 data + missing data 去推测下一步整个变量集的 distribution 。

基本想法:

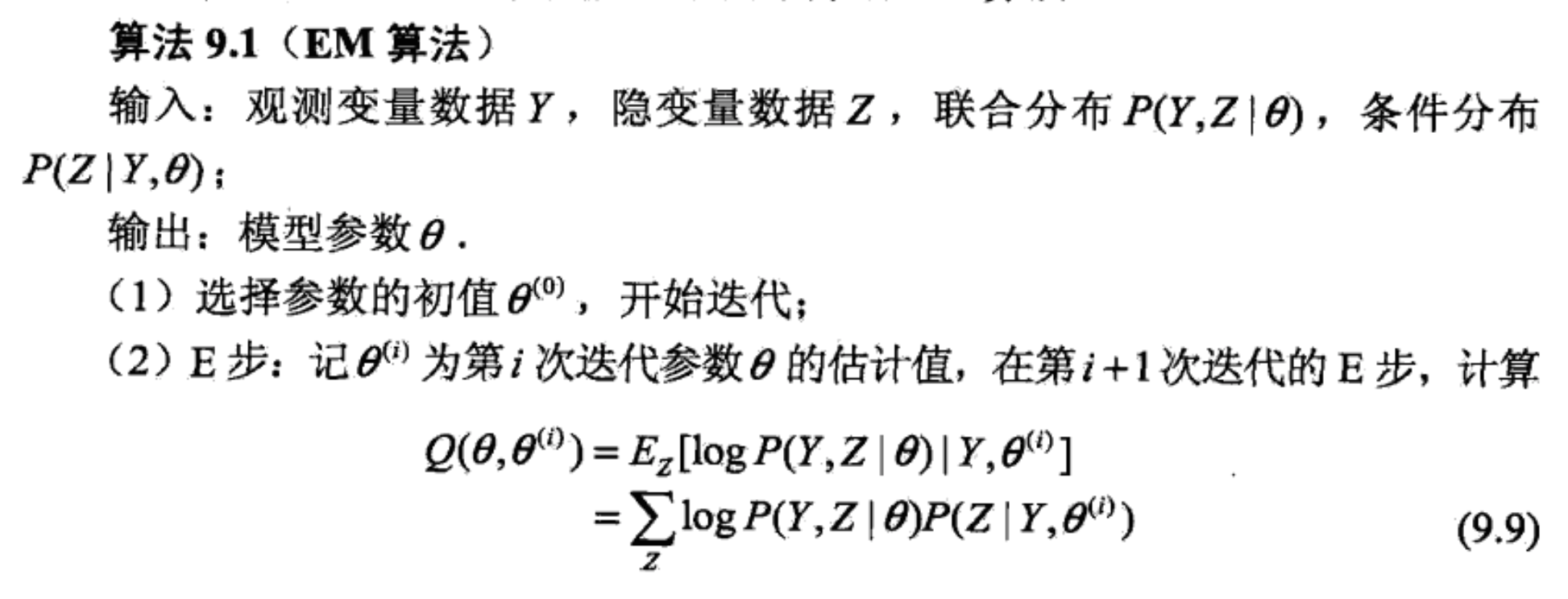

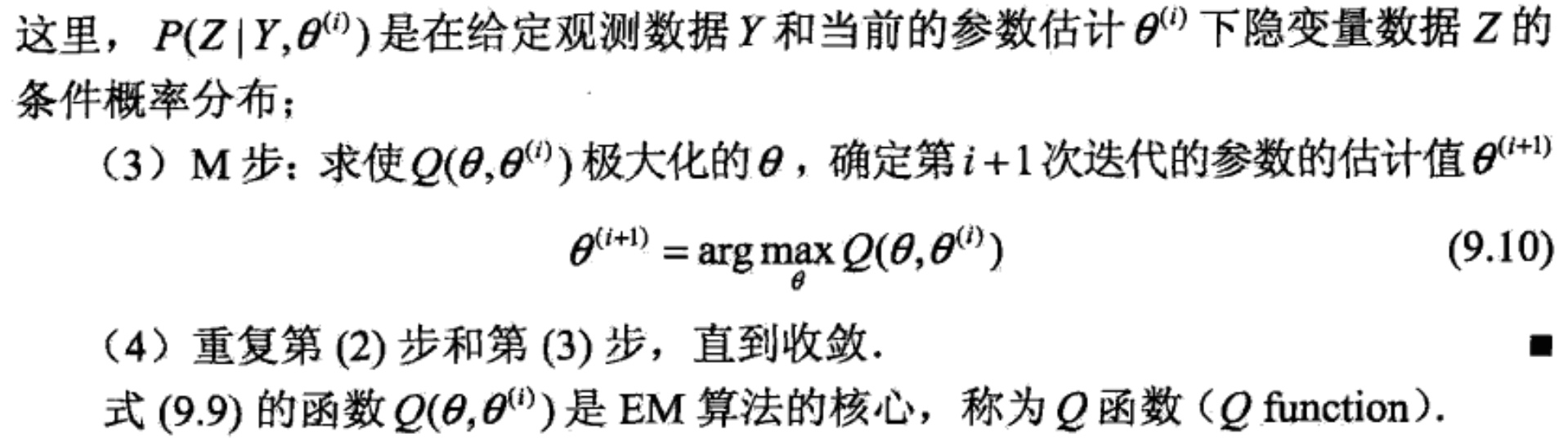

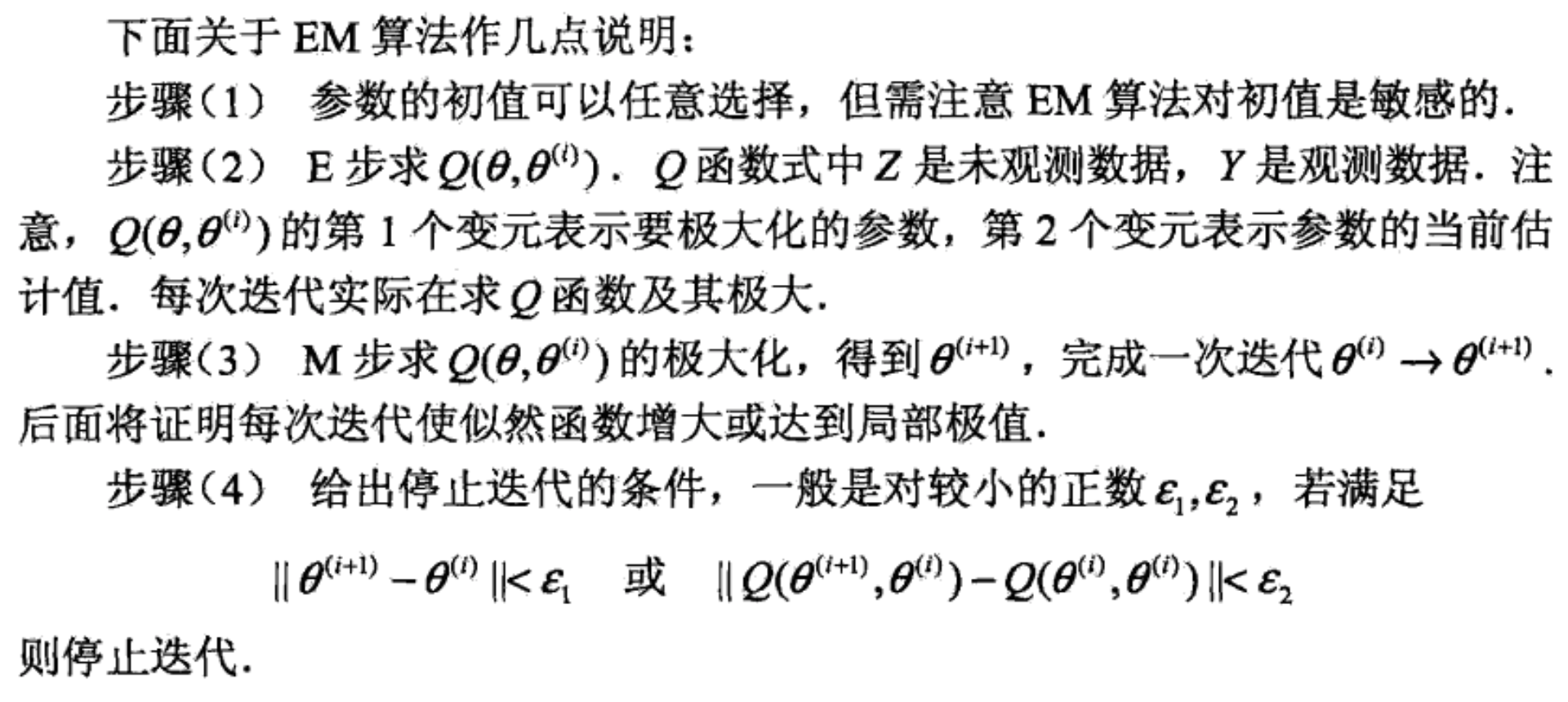

EM 算法:

EM 算法是一种坐标下降法 coordinate descent 来最大化对数似然下界的过程。

应用于高斯混合模型的参数估计、隐马尔科夫模型的非监督学习、k 均值聚类算法等处。

Ref

[1] 机器学习 - 周志华

[2] 统计学习方法